Après avoir vu comment installer Ollama et utiliser des modèles comme Mistral et LLaMA 3.2 en ligne de commande, une question revient souvent :

Peut-on utiliser Ollama avec une interface web, plus conviviale qu’un terminal ?

La réponse est oui. Dans cet article, nous allons voir comment utiliser une Web UI pour Ollama, afin d’interagir avec des modèles d’IA locale directement depuis un navigateur web.

Pourquoi utiliser une Web UI avec Ollama ?

L’interface en ligne de commande est parfaite pour :

- tester rapidement un modèle

- automatiser des tâches

- comprendre le fonctionnement d’Ollama

Mais elle montre vite ses limites pour un usage plus confortable.

Une Web UI permet notamment de :

- discuter avec les modèles via une interface type ChatGPT

- conserver l’historique des conversations

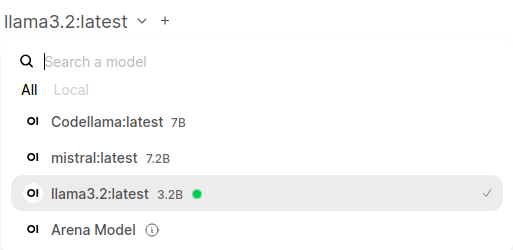

- changer de modèle facilement

- utiliser Ollama sans connaître les commandes CLI

C’est particulièrement intéressant pour :

- les tests fonctionnels

- la démonstration de l’IA locale

- les utilisateurs non techniques

Quelle Web UI pour Ollama ?

Il existe plusieurs projets permettant d’ajouter une interface web à Ollama. L’un des plus utilisés et des plus complets est :

Open WebUI (anciennement Ollama WebUI)

Ses avantages :

- interface moderne et intuitive

- compatible avec Ollama sans configuration complexe

- support de plusieurs modèles

- déploiement simple via Docker

C’est cette solution qui sera utilisée dans la suite.

Prérequis

Avant d’aller plus loin, il est nécessaire d’avoir :

- une machine sous Debian

- Ollama déjà installé et fonctionnel

- au moins 8 à 12 Go de RAM (selon les modèles utilisés)

- un accès administrateur

Dans mon cas, l’environnement est le suivant :

- Debian installé dans une machine virtuelle KVM

- 12 Go de mémoire

- exécution des modèles uniquement sur CPU

Principe de fonctionnement

Le fonctionnement est simple :

- Ollama continue de gérer les modèles et leur exécution

- la Web UI se connecte à l’API locale d’Ollama

- l’utilisateur interagit avec les modèles via son navigateur

Aucune donnée n’est envoyée vers l’extérieur : 👉 tout reste en local

C’est un point important en termes de confidentialité et de sécurité.

Déploiement de la Web UI

La méthode la plus simple pour déployer Open WebUI est d’utiliser Docker.

Docker permet :

- une installation rapide

- une isolation propre du service

- une suppression facile si besoin

Connexion à Ollama

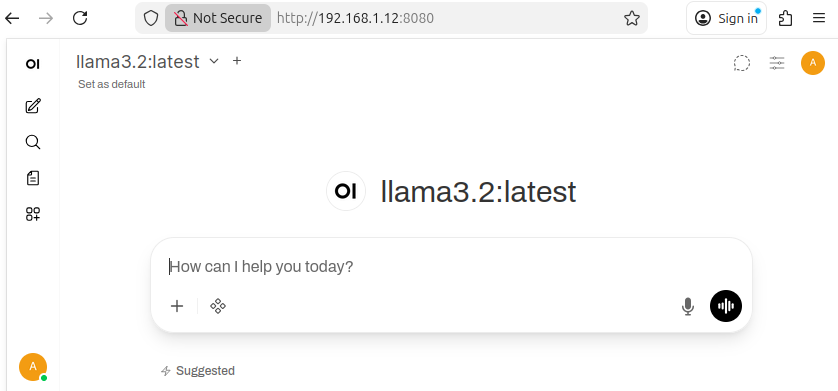

Une fois la Web UI lancée :

- elle détecte automatiquement Ollama

- les modèles déjà téléchargés (Mistral, LLaMA 3.2, etc.) sont disponibles

- il est possible de lancer des conversations immédiatement

Performances et limites

Sans GPU, il faut garder à l’esprit que :

- les temps de réponse sont plus longs

- les modèles volumineux consomment beaucoup de mémoire

Installation d’Open WebUI

L’installation d’Open WebUI se fait simplement à l’aide de Docker. Cette méthode évite toute installation complexe et permet de déployer rapidement l’interface.

Prérequis: validation de l’installation de docker et d’ollama

ob@debian:~$ docker --version

Docker version 29.1.4, build 0e6fee6

bob@debian:~$ systemctl status docker

● docker.service - Docker Application Container Engine

Loaded: loaded (/usr/lib/systemd/system/docker.service; enabled; preset: e>

Active: active (running) since Sat 2026-01-24 16:45:15 CET; 9min ago

Invocation: 057dd9278bae4635a709ec82ab131da3

TriggeredBy: ● docker.socket

Docs: https://docs.docker.com

Main PID: 865 (dockerd)

Tasks: 12

Memory: 116.7M (peak: 118.6M)

CPU: 1.432s

CGroup: /system.slice/docker.service

└─865 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/conta>

Warning: some journal files were not opened due to insufficient permissions.

bob@debian:~$

bob@debian:~$

bob@debian:~$ ollama --version

ollama version is 0.14.0

bob@debian:~$

bob@debian:~$ ss -antu | grep 11434

tcp LISTEN 0 4096 127.0.0.1:11434 0.0.0.0:*

bob@debian:~$

Lancement du conteneur

Une fois Docker installé sur Debian, Open WebUI peut être lancé avec la commande suivante :

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:mainL’interface est ensuite accessible depuis un navigateur à l’adresse du serveur openwebUI

Lors de la première connexion, un compte administrateur est créé.

Commandes de gestion du conteneur

Quelques commandes Docker utiles pour gérer Open WebUI :

- Démarrer le service :

bob@debian:~$ docker start open-webui

open-webui

- Arrêter le service :

bob@debian:~$ docker stop open-webui

open-webui- Redémarrer le service :

bob@debian:~$ docker restart open-webui

open-webui

bob@debian:~$- Afficher les logs :

bob@debian:~$ docker logs open-webui

Ces commandes permettent de gérer facilement le cycle de vie de la Web UI.

Téléchargement d’un modèle

Les modèles sont toujours gérés par Ollama.

Il est maintenant possible de télécharger un modèle depuis l’interface web (bouton « + »)

Premiers tests d’utilisation

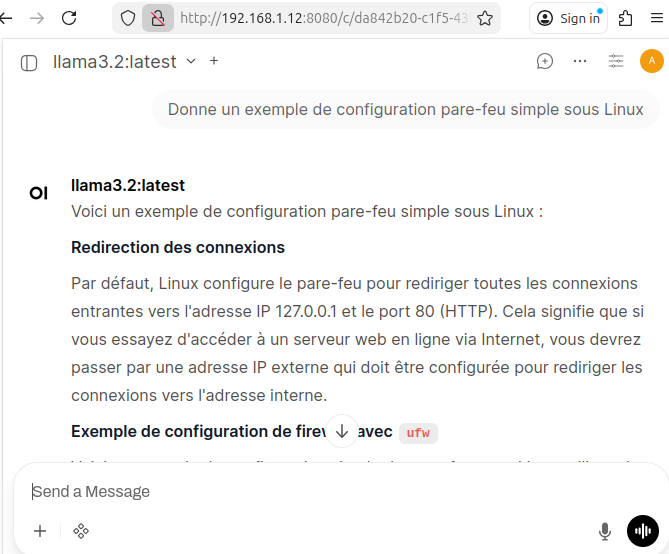

Depuis l’interface web :

- sélectionner le modèle souhaité (Mistral ou LLaMA 3.2)

- saisir une requête simple, par exemple :

Donne un exemple de configuration pare-feu simple sous Linux

Les réponses sont générées localement par Ollama et affichées directement dans le navigateur.

Il est possible de :

- changer de modèle à la volée

- conserver l’historique des conversations

- comparer les réponses entre plusieurs modèles

Conclusion

Ajouter une Web UI à Ollama permet de rendre l’IA locale :

- plus accessible

- plus conviviale

- plus facile à démontrer

Laisser un commentaire